👋 Chers Dancing Queens et Super Troupers,

On a longtemps parlé d’intelligence artificielle comme d’un truc un peu flou, coincé entre des promesses de conférences, des démos trop parfaites et des débats abstraits sur “l’impact potentiel”.

Pour cette première semaine 2026, changement d’ambiance. L’IA a cessé de lever la main pour demander la parole. Elle est entrée dans la pièce, a tiré une chaise… et a commencé à réorganiser le mobilier.

D’abord, il y a le bruit sec des chiffres. Deux cent mille emplois bancaires européens menacés d’ici la fin de la décennie. Pas par une crise financière, pas par un krach, mais par des algorithmes devenus suffisamment bons pour avaler des tâches entières de back-office, de conformité, d’analyse et de gestion des risques.

Ce n’est pas une prédiction futuriste, c’est un plan stratégique. L’IA ne “pourrait” plus transformer le travail. Elle le fait déjà, ligne par ligne, service par service, budget par budget.

Pendant ce temps, dans les labos de robotique, une autre frontière cède. Des humanoïdes commencent à réagir comme des organismes vivants. Une pression trop forte, une surface dangereuse, et le robot retire son bras avant même d’avoir “réfléchi”.

Pas parce qu’il comprend la douleur, mais parce qu’il a appris l’équivalent mécanique du réflexe. L’IA descend ici sous le niveau du raisonnement. Elle s’installe dans le réflexe, dans l’instant, dans le corps.

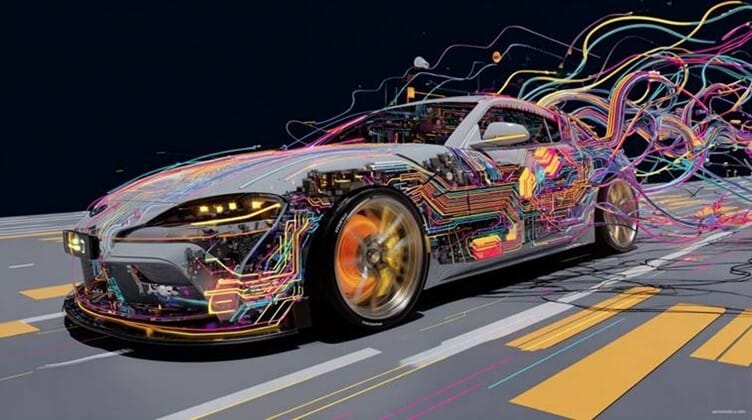

Et puis il y a cet autre changement, plus silencieux encore. L’IA quitte l’écran. Elle se glisse dans des objets sans interface, dans des voitures déjà en circulation, dans des boîtiers discrets ou des appareils de poche.

Plus besoin d’ouvrir une app, de taper une requête ou de fixer un écran. L’intelligence devient ambiante, contextuelle, presque invisible. Moins spectaculaire, infiniment plus efficace.

Ce qui relie toutes ces actus, ce n’est pas la technologie en elle-même. C’est le changement de statut. L’IA n’est plus un outil expérimental ni un assistant bavard. Elle devient une infrastructure. Elle redessine le travail qualifié, elle modifie la façon dont les machines interagissent avec nous, elle s’infiltre dans les objets que l’on pensait “terminés”.

Voici le sommaire de la semaine :

👉 Banques européennes : 200 000 emplois menacés par l’IA 🏦

👉 Peau robotique : des humanoïdes qui “ressentent” la douleur 🧬

👉 OpenAI veut mettre ChatGPT… dans un stylo 🖊️

👉 Un cerveau IA à brancher sur votre voiture 🚗

👉 Manus : le pari de Meta sur l’IA qui travaille seule 🤯

Si on t’a transféré cette lettre, abonne-toi en cliquant sur ce lien !

⚡ Si tu as une minute :

Les grandes banques du continent préparent une cure d’amaigrissement massive. Automatisation du back-office, de la conformité, de l’analyse des risques… l’IA fait le boulot plus vite, moins cher, sans pause déjeuner. Ce n’est plus une hypothèse, c’est un plan à horizon 2030.

Une nouvelle peau robotique permet aux humanoïdes de réagir instantanément à un contact dangereux, sans passer par un cerveau central. Comme un réflexe humain. Résultat : des robots plus sûrs, plus fluides, et beaucoup plus crédibles dans des environnements humains.

Un appareil en forme de stylo, discret, toujours à portée de main, capable d’interagir avec l’IA sans passer par un smartphone. L’objectif est clair : sortir l’IA de l’écran et la rendre permanente, contextuelle, presque invisible. Lancement visé : 2026-2027.

Un boîtier plug-and-play promet d’ajouter des capacités d’IA avancées à des voitures déjà en circulation. Calcul local, meilleure réactivité, nouvelles fonctions d’assistance. Une façon d’accélérer l’IA embarquée sans attendre les prochains modèles.

Meta ne veut plus seulement des chatbots. Avec Manus, il parie sur des agents IA autonomes capables d’agir, planifier et exécuter des tâches complexes. Un choix structurant face à OpenAI et Google.

🔥 Si tu as quinze minutes

1️⃣ Banques européennes : 200 000 emplois menacés par l’IA

Le résumé : Le secteur bancaire européen s’apprête à vivre une cure d’automatisation massive. D’après une analyse de Morgan Stanley relayée par TechCrunch et le Financial Times, plus de 200 000 emplois pourraient disparaître d’ici 2030. En cause : l’adoption accélérée de l’intelligence artificielle et la fermeture progressive des agences physiques, au nom de l’efficacité.

Les détails :

200 000 postes menacés : Morgan Stanley estime que 200 000 emplois bancaires pourraient être supprimés en Europe d’ici 2030, soit environ 10 % des effectifs de 35 grandes banques.

L’IA en première ligne : Les banques misent sur l’intelligence artificielle pour automatiser leurs opérations et réduire les coûts, avec des gains d’efficacité projetés à 30 %.

Les fonctions les plus touchées : Les coupes viseront surtout les fonctions support, la gestion des risques et la conformité, des domaines où les algorithmes analysent les données plus vite que les équipes humaines.

Agences en voie de disparition : La fermeture progressive des agences physiques accompagne cette transformation en accélérant la réduction des effectifs sur le terrain.

Goldman Sachs montre la voie : Aux États-Unis, Goldman Sachs a annoncé en octobre des suppressions de postes et un gel des embauches jusqu’à fin 2025, dans le cadre de son plan IA baptisé « OneGS 3.0 ».

ABN Amro tranche net : La banque néerlandaise prévoit de supprimer un cinquième de ses effectifs d’ici 2028, reflet de la radicalité de certains plans européens.

Société Générale sans tabou : Son PDG affirme que « rien n’est sacré », signalant que toutes les fonctions sont concernées par la transformation.

Une voix prudente : Un cadre de JPMorgan Chase alerte toutefois dans le Financial Times : priver les jeunes banquiers des fondamentaux pourrait fragiliser le secteur à long terme.

Pourquoi c’est important : Ces annonces marquent un tournant social majeur. L’IA promet efficacité et rentabilité, mais redessine brutalement l’emploi bancaire. Derrière les chiffres, c’est toute la transmission des compétences financières qui se retrouve sous pression.

2️⃣ Peau robotique : des humanoïdes qui “ressentent” la douleur

Le résumé : En Chine, des chercheurs viennent de développer une peau électronique neuromorphique capable de détecter le toucher, les blessures et même la douleur. Inspirée du système nerveux humain, cette technologie permet aux robots de réagir instantanément à un contact dangereux, sans attendre l’analyse d’un processeur central.

Les détails :

Une limite historique dépassée : Jusqu’ici, les robots humanoïdes dépendaient d’un traitement centralisé. Les signaux des capteurs devaient être analysés avant toute réaction et génère des délais parfois critiques.

Le réflexe humain comme modèle : Chez l’humain, un objet brûlant déclenche un retrait quasi immédiat via la moelle épinière. Cette peau électronique reproduit ce mécanisme réflexe.

Une peau qui comprend le danger : Contrairement aux capteurs classiques, la peau NRE détecte un contact et évalue si l’interaction présente un risque réel.

Une architecture neuromorphique : La technologie repose sur une organisation hiérarchique inspirée des neurones. Les signaux tactiles sont transformés en impulsions électriques similaires à celles des nerfs humains.

Quatre couches bien distinctes : La couche externe joue un rôle protecteur, comme l’épiderme. En dessous, des capteurs et des circuits surveillent en continu la pression, la force et l’intégrité de la surface.

Un diagnostic permanent : Même sans contact, la peau envoie régulièrement des impulsions électriques au processeur central, confirmant que tout fonctionne normalement.

Détection immédiate des blessures : En cas de coupure ou de dommage, les impulsions cessent. Le robot localise alors précisément la zone affectée.

Réflexes sans passer par le “cerveau” : Si la pression dépasse un seuil critique, un signal haute tension est envoyé directement aux moteurs. Le robot retire instantanément un bras ou une main.

Sécurité et empathie : Les chercheurs expliquent que cette conception améliore le toucher, la sécurité et l’interaction intuitive homme-robot, notamment pour les robots de service empathiques.

Pourquoi c’est important : En dotant les robots d’une forme de “douleur”, cette peau électronique rapproche les humanoïdes des réflexes humains. Elle réduit les risques d’accident, améliore la cohabitation avec l’homme et prépare l’arrivée de robots réellement adaptés aux foyers, hôpitaux et espaces publics. La robotique cesse d’être rigide, elle devient instinctive.

3️⃣ OpenAI veut mettre ChatGPT… dans un stylo

Le résumé : OpenAI prépare son premier appareil grand public qui prendra la forme d’un stylo intelligent, Selon Wccftech, Pensé avec Jony Ive, ex-directeur du design d’Apple, l’objet vise à installer l’IA comme nouvel outil central du quotidien, au-delà du smartphone. Ce stylo intelligent, baptisé « Gumdrop », arrivera entre 2026 et 2027.

Les détails :

Un projet matériel assumé : OpenAI collabore avec Jony Ive sur plusieurs appareils destinés au grand public, avec l’objectif affiché de concurrencer l’iPhone grâce à la productivité assistée par IA.

Un design minimaliste : L’appareil adopte un format proche d’un iPod Shuffle. Compact, il se glisse dans une poche ou se porte autour du cou, sans écran intégré.

Des capteurs en première ligne : Caméras et microphones permettent une perception contextuelle avancée, afin de comprendre l’environnement de l’utilisateur.

IA locale et cloud hybride : Les modèles d’IA personnalisés d’OpenAI fonctionneront directement sur l’appareil, avec un appui du cloud pour les tâches plus lourdes.

Notes manuscrites connectées et intercommunication : Les écrits à la main seront transformés en texte numérique et envoyés instantanément vers ChatGPT. Le stylo pourra échanger avec d’autres dispositifs, à l’image des interactions actuelles entre smartphones.

Une production sous tension géopolitique : Prévue d’abord chez Luxshare en Chine, la fabrication pourrait finalement être confiée à Foxconn, au Vietnam ou aux États-Unis, pour un lancement entre 2026 et 2027.

Pourquoi c’est important : Avec ce stylo IA, OpenAI amorce son entrée dans le matériel grand public. Un virage stratégique qui cherche à faire sortir l’IA des écrans pour l’ancrer dans les gestes du quotidien, tout en contestant la domination du smartphone.

4️⃣ Un cerveau IA à brancher sur votre voiture

Le résumé : Au CES 2026, BOS Semiconductors dévoilera un boîtier d’intelligence artificielle enfichable pensé pour moderniser les voitures sans toucher à leur architecture interne. Baptisée AI Box, cette solution promet d’apporter des capacités d’IA avancées aux véhicules existants comme aux nouveaux modèles. Une approche pragmatique, présentée à Las Vegas du 6 au 9 janvier 2026, qui vise à accélérer l’adoption de l’IA dans la mobilité.

Les détails :

Un boîtier externe, zéro chirurgie : L’AI Box se connecte directement à l’électronique embarquée existante. Elle évite le remplacement des systèmes d’infodivertissement ou des plateformes du véhicule.

BOS Semiconductors à la manœuvre : L’entreprise sud-coréenne, basée à Seongnam, se spécialise dans les semi-conducteurs dédiés à l’IA physique et automobile.

Un accélérateur pour l’IA automobile : Le module soutient la conduite autonome, les véhicules à définition logicielle (SDV) et l’essor de l’IA physique appliquée à la mobilité.

CNN, transformeurs et décisions en temps réel : L’AI Box prend en charge des modèles basés sur les réseaux de neurones convolutifs et les transformeurs, avec une prise de décision rapide dans le monde réel.

IA embarquée, données protégées : La voix et la vidéo sont traitées directement dans le véhicule pour renforcer la confidentialité et la sécurité, sans dépendre du cloud.

Une vision assumée : Jason Jeongseok Chae, vice-président de BOS Semiconductors, affirme vouloir dépasser le rôle de fournisseur automobile pour devenir un acteur central de l’IA physique.

Pourquoi c’est important : Avec l’AI Box, l’IA automobile devient modulaire et accessible. Cette approche pourrait transformer des millions de voitures existantes en véhicules intelligents, sans attendre une nouvelle génération de modèles. Une petite boîte, mais un grand raccourci vers la voiture définie par logiciel..

5️⃣ Manus : le pari de Meta sur l’IA qui travaille seule

Le résumé : Meta rachète l’entreprise Manus, start-up chinoise d’IA basée à Singapour. L’opération, évaluée à plus de 2 milliards de dollars, renforce Meta AI avec des agents quasi autonomes. Mark Zuckerberg poursuit sa stratégie d’IA personnelle en multipliant investissements et acquisitions de talents.

Les détails :

Une acquisition stratégique : Meta confirme le rachat de Manus, valorisé à plus de 2 milliards de dollars, afin d’accélérer le développement de ses agents intelligents intégrés à ses produits grand public et professionnels, dont Meta AI.

Des agents vraiment autonomes : Manus revendique un agent capable de planifier, exécuter et finaliser des tâches sans échanges répétés, là où les chatbots classiques demandent de multiples requêtes.

Une vision alignée avec Zuckerberg : Barton Crockett, analyste chez Rosenblatt Securities, décrit ce choix comme naturel, cohérent avec la vision de Mark Zuckerberg autour d’une IA personnelle pilotée par des agents.

Une mission assumée : Manus affirme vouloir “étendre la portée humaine”, en assistant le travail plutôt qu’en le remplaçant, une philosophie que Meta dit vouloir préserver.

Continuité et gouvernance : Xiao Hong, PDG et cofondateur, assure que Manus conservera son fonctionnement interne et ses décisions, tout en continuant à exploiter et vendre son service sous l’égide de Meta.

Une offensive IA plus large : En juin, Meta a déjà investi 14 milliards de dollars pour acquérir 49 % de Scale AI et attirer son dirigeant. Cela illustre une montée en puissance face à des acteurs comme OpenAI.

Pourquoi c’est important : Meta consolide sa position dans la course mondiale à l’IA en misant sur des agents autonomes, un pari technologique qui pourrait transformer la manière dont les utilisateurs délèguent leurs tâches numériques au quotidien.

❤️ L’outil de la semaine : ChatGPT vous résume votre année

ChatGPT se met au bilan de fin d’année. OpenAI déploie une rétrospective personnalisée façon Spotify Wrapped, qui transforme ton historique de conversations en une expérience ludique, graphique et étonnamment introspective.

À quoi ça sert ?

Revoir comment tu as utilisé ChatGPT sur l’année, thèmes dominants, types de demandes, habitudes.

Découvrir des “récompenses” personnalisées selon ton usage, du genre Creative Debugger ou penseur compulsif à 2h du matin.

Générer automatiquement un poème et une image qui résument ton année IA, basés sur tes centres d’intérêt.

Prendre conscience de la place réelle qu’a prise l’IA dans ton quotidien, ton travail, ta créativité.

Pourquoi c’est malin

Ce n’est pas un gadget de plus. C’est une façon très habile de normaliser la relation à l’IA, de la rendre personnelle, presque intime, sans forcer l’usage. OpenAI transforme un historique de logs en objet émotionnel, tout en rappelant que l’IA n’est plus seulement un outil ponctuel, mais un compagnon de pensée régulier.

Comment l’utiliser

Avoir l’historique de discussions et la mémoire activés.

Être sur un compte Free, Plus ou Pro (hors Team, Enterprise, Education).

Attendre la mise en avant sur l’écran d’accueil… ou simplement demander à ChatGPT :

“Your Year with ChatGPT”

Un Wrapped qui ne parle pas de musique, mais de ce que tu cherches, doutes, construis. Et ça, c’est peut-être encore plus révélateur !

💙 La vidéo de la semaine : quand entraîner un robot humanoïde devient… douloureux

Une vidéo virale montre un téléopérateur en train d’entraîner le robot humanoïde G1 de Unitree via téléopération. Le principe est simple : l’humain exécute des mouvements, le robot les imite en temps réel. Sauf que cette fois, l’exercice inclut des coups de pied d’arts martiaux… et que le robot copie tout. Absolument tout.

Résultat : un coup mal anticipé, le robot reproduit le geste à l’identique, et l’opérateur se retrouve à terre, plié de douleur, pendant que le robot s’effondre lui aussi. Synchronisation parfaite. Mauvais timing.

Derrière le côté viral et un peu cruel de la scène, la vidéo dit quelque chose de très sérieux. Les humanoïdes sont désormais assez rapides, précis et puissants pour que leur entraînement physique devienne risqué. La téléopération, utilisée pour nourrir l’imitation learning, n’est plus un jeu sans conséquences quand les machines gagnent en force et en autonomie.

Cette séquence marque un tournant discret mais important : on entre dans une phase où entraîner un robot demande les mêmes précautions que travailler avec une machine industrielle lourde. Les humanoïdes ne sont plus fragiles, ni lents. Ils apprennent vite… et frappent juste.

Une vidéo qui fait sourire jaune, mais qui rappelle une chose essentielle : à mesure que les robots deviennent plus humains dans leurs mouvements, ils héritent aussi de leur potentiel de danger.

Une IA toujours là, sans écran, tu signes ?